Nun könnte man ja auch sagen: Vertrauen ist gut, die Vermeidung jeglichen staatlichen Zugriffs ist besser.

Aus Sicht des Schutzes vor Massenüberwachung ist die dezentrale Lösung auf jeden Fall vorzuziehen. Hat man aber Angst vor Stigmatisierung der Infizierten, dann ist eine eher zentralisierte Lösung besser. Es gibt also Unterschiede, aber die sind subtil.

Was würden Sie nun vorschlagen?

Wenn man mich jetzt ganz pragmatisch fragt: Ich würde möglichst schnell eine App bringen, und würde dann aber sagen, dass es einen Stichtag geben muss, an dem diese App entweder komplett abgeschaltet und die Daten gelöscht sein müssen oder sie abgelöst wird durch eine noch besser entwickelte App. Es ist schon jetzt ziemlich gut, was vorgeschlagen wird, und ich fände es schade, wenn diese Diskussion jetzt diesen App-Ansatz verhindert. Denn ich glaube, dass ein besseres Tracing – bessere Warnmöglichkeiten, eine bessere Rückverfolgung der Infektionsketten – weitere Lockerungen der Corona-Maßnahmen ermöglichen könnte. Diese Maßnahmen sind ja Einschränkungen unserer Grundrechte, und wenn nun eine App helfen kann, diese zurückzunehmen, dann wäre ich im Moment ein bisschen pragmatisch. Sofern bestimmte Kriterien eingehalten werden.

Im offenen Brief der 300 Wissenschaftler sind vier zentrale Anforderungen genannt: Neben dem Schutz der Privatsphäre sind dies noch Zweckbindung, Transparenz und Freiwilligkeit.

Zentral ist, dass alle Leute, die mit den Daten in Berührung kommen, sich verpflichten müssten – und dafür haften müssten –, dass die Grundregeln der Datenschutzgrundverordnung eingehalten werden. Und da ist der wichtigste Punkt die Zweckbindung. Das heißt, auf keinen Fall dürfen diese Daten für irgendetwas anderes – etwa Marketing – verwendet werden, sondern wirklich nur für diese Medizinanwendung.

Zur Forderung nach Transparenz, dass der Quellcode einsichtig ist. Was ist daran so wichtig?

Wenn der Quellcode nicht einsichtig ist, dann ist die Anwendung für Sie wie eine Black Box. Das heißt, Sie wissen im schlimmsten Fall gar nicht, ob diese Pseudonyme, die beispielsweise ausgesendet werden, nicht doch irgendwie heimlich Ihren Namen enthalten. Und wenn man jetzt die Gelegenheit hätte, auf ganz viele Handys unter dem Deckmantel der guten Tat eine Überwachungs-App aufzuspielen, dann kann man so etwas nur durch Transparenz verhindern.

Transparenz betrifft ja zum einen die App als solche, zum anderen aber auch die Schnittstellen, die das Betriebssystem des Handys enthalten muss, damit die App überhaupt läuft. Und die Betriebssysteme sind meistens von Apple und Google, die sich im Falle der Tracing-Apps zwar sehr entgegenkommend zeigen, aber deren Rolle angesichts ihrer Datensammelwut auch sehr kritisch gesehen wird.

Zu allererst finde ich es gut, dass Google und Apple sagen, wir wollen es bestimmten Apps ermöglichen, selbst wenn die App nicht im Vordergrund läuft, im Hintergrund Bluetooth verwenden zu dürfen. Das ist zu Recht den meisten Apps verboten, weil die sonst wer weiß was für Schindluder treiben würden. Einerseits also erst einmal positiv. Andererseits ist es natürlich so, dass wir zu Recht ein tiefes Misstrauen haben, wenn Unternehmen, die mit Daten Geld verdienen, diese Daten auch irgendwie mitverwalten. Und das ist leider ein gewisses Problem, bei dem ich im Moment auch noch nicht weiß, wie eine Lösung aussehen könnte. Zumal Apple und Google gar nicht unter europäischer Gerichtsbarkeit stehen. Und zumal sie, falls sie irgendeine Zusatzfunktion einbauen würden, es wahrscheinlich so raffiniert machen würden, dass es letztlich doch irgendwie gesetzeskonform wäre. Oder Sie in den AGBs doch wieder zustimmen würden.

Für wie wahrscheinlich halten Sie das?

Im Moment denke ich tatsächlich: Wenn die jetzt mit Daten Schindluder treiben würden, wo es um Gesundheit geht, und bei einer App, bei der alle Leute Angst vor Missbrauch der Daten haben, wäre es für diese Firmen echt geschäftsschädigend, wenn es herauskäme. Ich würde mir trotzdem prinzipiell Gedanken machen, ob es auch irgendwie anders geht, aber ich glaube, andere Lösungen sind momentan sehr, sehr schwierig – man bräuchte vielleicht spezielle kleine Bluetooth-Geräte, die wir alle noch nicht haben.

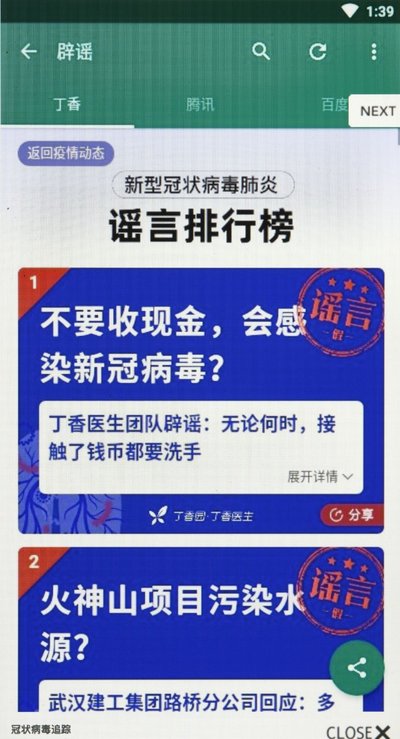

Für Unruhe im Netz sorgte kürzlich das Gerücht, dass so eine App automatisch bei System-Updates aufgespielt werden soll. Wie beurteilen Sie das?

Das ist meines Erachtens sehr schwer zu beurteilen, denn ich glaube – aber ich bin kein Jurist –, ein automatisches Aufspielen ist noch kein Zwang, sofern die App noch nicht angeschaltet ist. Analog zu anderen Apps, die Ihnen vorgeschlagen werden, wenn Sie ein neues Smartphone gekauft haben, und die auch nicht automatisch an sind. Natürlich wäre für mich ein Problem da, wenn es beispielsweise eine europäische Lösung und eine amerikanische Lösung gäbe, und die amerikanische wäre vorab aufgespielt und würde sich nur insoweit an die Datenschutzgrundverordnung halten, dass man den AGBs zugestimmt hat, aber danach würden die Daten von Apple oder Google anders verwendet. Das fände ich tatsächlich schlimm. Aber wenn es die gleiche App wäre, bei der ich glücklich wäre, wenn wirklich ein substanzieller Teil der Bevölkerung sie bei sich hätte, dann fände ich es gut, wenn sie vorab aufgespielt wäre.

4 Kommentare verfügbar

-

Antworten

Mich verwundert an dieser (sehr notwendigen) Diskussion nur, dass keiner auf die Idee kommt und ansagt, dass wir uns jetzt doch bitte jeden Abend drei Minuten Zeit nehmen und aufschreiben, mit wem wir an dem gerade vergangenen Tag bewusst Kontakt gehabt haben.

Kommentare anzeigenMichael Schenk

am 11.05.2020Diese Vorgehensweise ist lang nicht…